Bạn muốn học quét web bằng Python nhưng lại bối rối không biết nên sử dụng Beautiful Soup, Selenium hay Scrapy cho dự án tiếp theo của mình? Mặc dù tất cả các thư viện và khung Python này đều mạnh mẽ theo cách riêng của chúng, nhưng chúng không phục vụ cho tất cả các nhu cầu quét web và do đó, điều quan trọng là phải biết bạn nên sử dụng công cụ nào cho một công việc cụ thể.

Chúng ta hãy xem xét sự khác biệt giữa Beautiful Soup, Scrapy và Selenium, để bạn có thể đưa ra quyết định sáng suốt trước khi bắt đầu dự án quét web Python tiếp theo của mình.

1. Dễ sử dụng

Nếu bạn là người mới bắt đầu, yêu cầu đầu tiên của bạn là một thư viện dễ học và dễ sử dụng. Beautiful Soup cung cấp cho bạn tất cả các công cụ thô sơ bạn cần để quét web và nó đặc biệt hữu ích cho những người có ít kinh nghiệm với Python nhưng muốn bắt đầu bằng việc quét web.

Lưu ý duy nhất là, do tính đơn giản của nó, Beautiful Soup không mạnh bằng Scrapy hoặc Selenium. Các lập trình viên có kinh nghiệm phát triển có thể dễ dàng thành thạo cả Scrapy và Selenium, nhưng đối với người mới bắt đầu, dự án đầu tiên có thể mất nhiều thời gian để xây dựng nếu họ chọn sử dụng các khung này thay vì Beautiful Soup.

Để cạo nội dung thẻ tiêu đề trên example.com bằng Beautiful Soup, bạn sẽ sử dụng mã sau:

url = "https://example.com/"

res = requests.get(url).text

soup = BeautifulSoup(res, 'html.parser')

title = soup.find("title").text

print(title)

Để đạt được kết quả tương tự khi sử dụng Selenium, bạn nên viết:

url = "https://example.com"

driver = webdriver.Chrome("path/to/chromedriver")

driver.get(url)

title = driver.find_element(By.TAG_NAME, "title").get_attribute('text')

print(title)

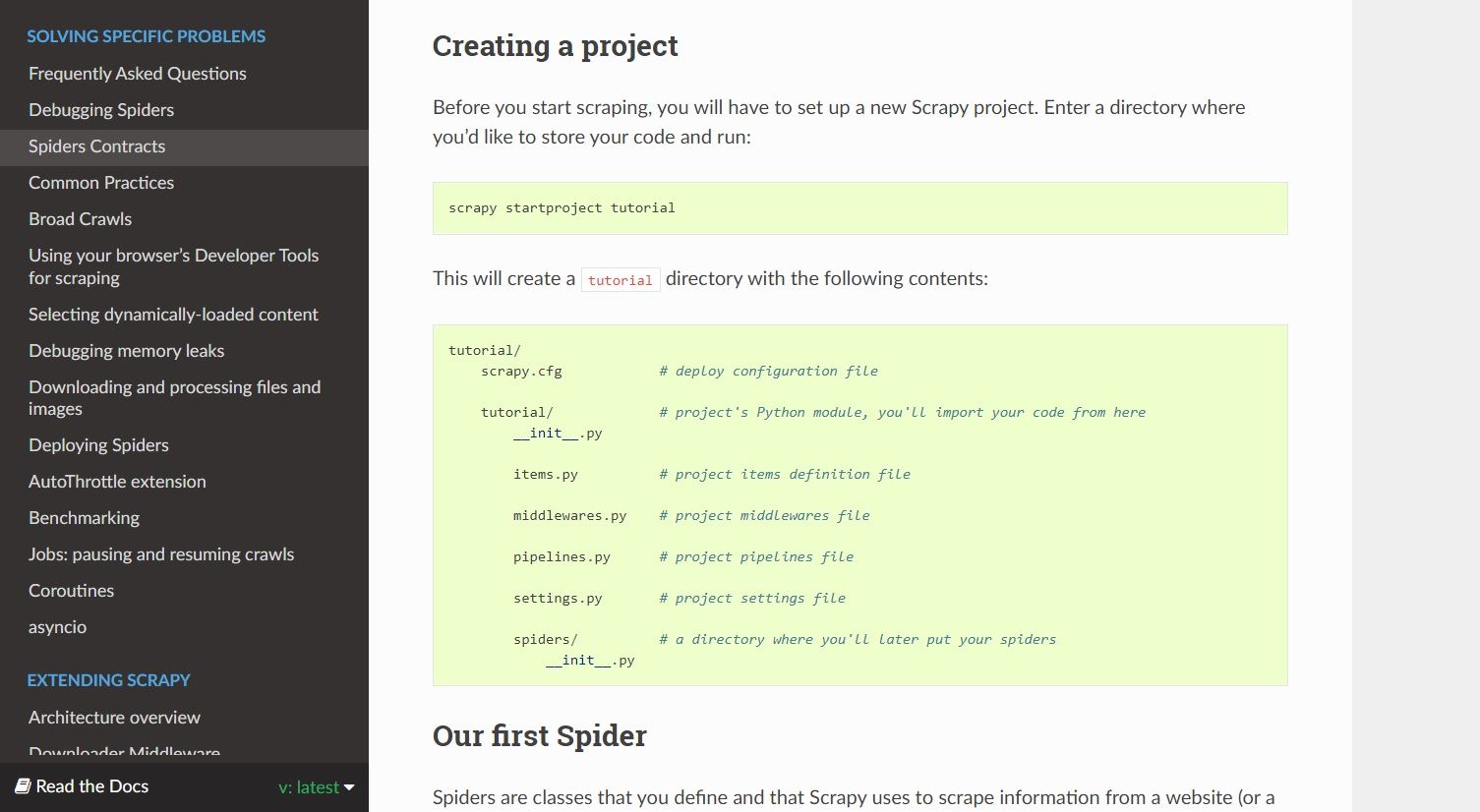

Cấu trúc tệp của một dự án Scrapy bao gồm nhiều tệp, làm tăng thêm độ phức tạp của nó. Đoạn mã sau loại bỏ tiêu đề từ example.com:

import scrapy

class TitleSpider(scrapy.Spider):

name = 'title'

start_urls = ['https://example.com']

def parse(self, response):

yield {

'name': response.css('title'),

}

Nếu bạn muốn trích xuất dữ liệu từ một dịch vụ cung cấp API chính thức, thì việc sử dụng API này thay vì phát triển một công cụ quét web có thể là một quyết định sáng suốt.

2. Tốc độ cạo và song song hóa

Trong số ba người, Scrapy rõ ràng là người chiến thắng về tốc độ. Điều này là do nó hỗ trợ song song hóa theo mặc định. Sử dụng Scrapy, bạn có thể gửi nhiều yêu cầu HTTP cùng một lúc và khi tập lệnh đã tải xuống mã HTML cho nhóm yêu cầu đầu tiên, tập lệnh sẽ sẵn sàng gửi một đợt khác.

Với Beautiful Soup, bạn có thể sử dụng thư viện luồng để gửi các yêu cầu HTTP đồng thời, nhưng điều này không thuận tiện và bạn sẽ phải học đa luồng để thực hiện điều đó. Trên Selenium, không thể song song hóa mà không khởi chạy nhiều phiên bản trình duyệt.

Nếu bạn xếp hạng ba công cụ quét web này về tốc độ, thì Scrapy là nhanh nhất, tiếp theo là Beautiful Soup và Selenium.

3. Sử dụng bộ nhớ

Selenium là một API tự động hóa trình duyệt, đã tìm thấy các ứng dụng của nó trong lĩnh vực quét web. Khi bạn sử dụng Selenium để quét một trang web, nó sẽ tạo ra một phiên bản trình duyệt không đầu chạy trong nền. Điều này làm cho Selenium trở thành một công cụ sử dụng nhiều tài nguyên khi so sánh với Beautiful Soup và Scrapy.

Vì cái sau hoạt động hoàn toàn trong dòng lệnh, nên chúng sử dụng ít tài nguyên hệ thống hơn và mang lại hiệu suất tốt hơn Selenium.

4. Yêu cầu phụ thuộc

Beautiful Soup là tập hợp các công cụ phân tích cú pháp giúp bạn trích xuất dữ liệu từ các tệp HTML và XML. Nó tàu với không có gì khác. Bạn phải sử dụng các thư viện như yêu cầu hoặc urllib để thực hiện các yêu cầu HTTP, trình phân tích cú pháp tích hợp sẵn để phân tích cú pháp HTML/XML và các thư viện bổ sung để triển khai proxy hoặc hỗ trợ cơ sở dữ liệu.

Mặt khác, Scrapy đi kèm với toàn bộ shebang. Bạn có các công cụ để gửi yêu cầu, phân tích cú pháp mã đã tải xuống, thực hiện các thao tác trên dữ liệu được trích xuất và lưu trữ thông tin cóp nhặt. Bạn có thể thêm các chức năng khác vào Scrapy bằng tiện ích mở rộng và phần mềm trung gian, nhưng điều đó sẽ đến sau.

Với Selenium, bạn tải xuống trình điều khiển web cho trình duyệt mà bạn muốn tự động hóa. Để triển khai các tính năng khác như lưu trữ dữ liệu và hỗ trợ proxy, bạn cần có các mô-đun của bên thứ ba.

5. Chất lượng tài liệu

Nhìn chung, mỗi tài liệu của dự án đều có cấu trúc tốt và mô tả mọi phương pháp bằng các ví dụ. Nhưng hiệu quả của tài liệu dự án cũng phụ thuộc rất nhiều vào người đọc.

Tài liệu của Beautiful Soup tốt hơn nhiều cho những người mới bắt đầu tìm kiếm trên web. Selenium và Scrapy có tài liệu chi tiết, chắc chắn rồi, nhưng biệt ngữ kỹ thuật có thể khiến nhiều người mới mất cảnh giác.

Nếu bạn đã có kinh nghiệm với các khái niệm và thuật ngữ lập trình, thì một trong ba tài liệu này sẽ rất dễ đọc.

6. Hỗ trợ Tiện ích mở rộng và Phần mềm trung gian

Scrapy là khuôn khổ Python quét web có thể mở rộng nhất. Nó hỗ trợ phần mềm trung gian, tiện ích mở rộng, proxy, v.v. và giúp bạn phát triển trình thu thập dữ liệu cho các dự án quy mô lớn.

Bạn có thể viết các trình thu thập dữ liệu hiệu quả và hoàn hảo bằng cách triển khai phần mềm trung gian trong Scrapy, về cơ bản là các móc bổ sung chức năng tùy chỉnh vào cơ chế mặc định của khung. Ví dụ: HttpErrorMiddleware xử lý các lỗi HTTP để trình thu thập thông tin không phải xử lý chúng trong khi xử lý yêu cầu.

Phần mềm trung gian và tiện ích mở rộng chỉ dành riêng cho Scrapy nhưng bạn có thể đạt được kết quả tương tự với Beautiful Soup và Selenium bằng cách sử dụng các thư viện Python bổ sung.

7. Kết xuất JavaScript

Selenium có một trường hợp sử dụng trong đó nó vượt qua các thư viện quét web khác, đó là quét các trang web hỗ trợ JavaScript. Mặc dù bạn có thể cạo các phần tử JavaScript bằng cách sử dụng phần mềm trung gian Scrapy, nhưng quy trình làm việc của Selenium là dễ dàng và thuận tiện nhất.

Bạn sử dụng một trình duyệt để tải một trang web, tương tác với nó bằng cách nhấp chuột và nhấn nút, và khi bạn có nội dung bạn cần cạo trên màn hình, hãy giải nén nó bằng cách sử dụng bộ chọn CSS và XPath của Selenium.

Beautiful Soup có thể chọn các thành phần HTML bằng bộ chọn XPath hoặc CSS. Tuy nhiên, nó không cung cấp chức năng để loại bỏ các phần tử được hiển thị bằng JavaScript trên một trang web.

Quét web dễ dàng với Python

Internet chứa đầy dữ liệu thô. Quét web giúp chuyển đổi dữ liệu này thành thông tin có ý nghĩa có thể được sử dụng tốt. Selenium có lẽ là lựa chọn an toàn nhất nếu bạn muốn quét một trang web bằng JavaScript hoặc cần kích hoạt một số phần tử trên màn hình trước khi trích xuất dữ liệu.

Scrapy là một khung tìm kiếm web chính thức đáp ứng mọi nhu cầu của bạn, cho dù bạn muốn viết một trình thu thập dữ liệu nhỏ hay một trình quét quy mô lớn liên tục thu thập dữ liệu trên internet để cập nhật dữ liệu.

Bạn có thể sử dụng Beautiful Soup nếu bạn là người mới bắt đầu hoặc cần nhanh chóng phát triển một cái cạp. Bất kể khung hoặc thư viện nào bạn sử dụng, thật dễ dàng để bắt đầu học quét web bằng Python.